Die Zusammenarbeit von Mensch und Roboter wird nicht nur in der Industrie immer wichtiger, auch die Pflege hat einen hohen Bedarf an Unterstützung durch Roboter. Doch bei der Kollaboration gibt es ein entscheidendes Hindernis: Roboter können noch nicht erkennen, ob der mitarbeitende Mensch aufmerksam, abgelenkt oder müde ist. Neurologische Analysen mit Elektroden kommen hier nicht infrage. Die TU Clausthal entwickelt eine alternative, kontaktlose Methode, indem eine Kamera die Augen-Pupillen vermisst.

Abb. 1: Die Zusammenarbeit zwischen Roboter und Mensch kann erst dann so flüssig wie zwischen zwei Personen ablaufen, wenn der Roboter menschliche Emotionen einschätzen und darauf reagieren kann. (© TU Clausthal)

Optisches EEG für Mensch-Roboter-Schnittstellen

Kollaborierende Roboter unterstützen den Menschen bei schwierigen Tätigkeiten, zum Beispiel beim Heben und exakten Positionieren von schweren Komponenten, oder bei der Versorgung von Pflegebedürftigen. Allerdings ist ein echtes Hand-in-Hand-Arbeiten von Mensch und Roboter, wie es zwischen zwei Menschen oder zwei Robotern möglich ist, noch immer eine Zukunftsvision. Der Grund hierfür liegt beim Menschen, dessen Verhalten von seinem emotionalen Zustand abhängt. Eine aufgewühlte, angeregte Person verhält sich anders als eine gelangweilte, müde Person. Wir Menschen können uns auf diese Unterschiede einstellen, Roboter bisher nicht. Das sind auch entscheidende Sicherheitsfragen bei Mensch-Maschine-Arbeitsplätzen.

Rückschlüsse auf emotionale Zustände ziehen

Wie Emotionen und Vertrauen Einzug in die Zusammenarbeit von Mensch und Roboter finden können, erforscht die Technische Universität Clausthal mit der Universität Göttingen und der Universität Duisburg-Essen. Das Land Niedersachsen fördert das Verbundprojekt „Kognitiv und Empathisch Intelligente Kollaborierende Roboter – KEIKO“ im SPRUNG-Programm. „Wir untersuchen, wie sich Messdaten, die Rückschlüsse auf emotionale Zustände erlauben, kontaktlos für den Roboter gewinnen lassen“, berichtet Prof. Dr. Christian Rembe, Leiter der Clausthaler Arbeitsgruppe Messtechnik. Um Zustände wie Aufmerksamkeit oder Ablenkung zu bewerten, wird bisher die Elektroenzephalographie (EEG) eingesetzt. Die EEG als Kontakttechnik ist allerdings für eine Mensch-Roboter-Kollaboration ungeeignet.

Kontaktlose optische Messung von Gehirnströmen

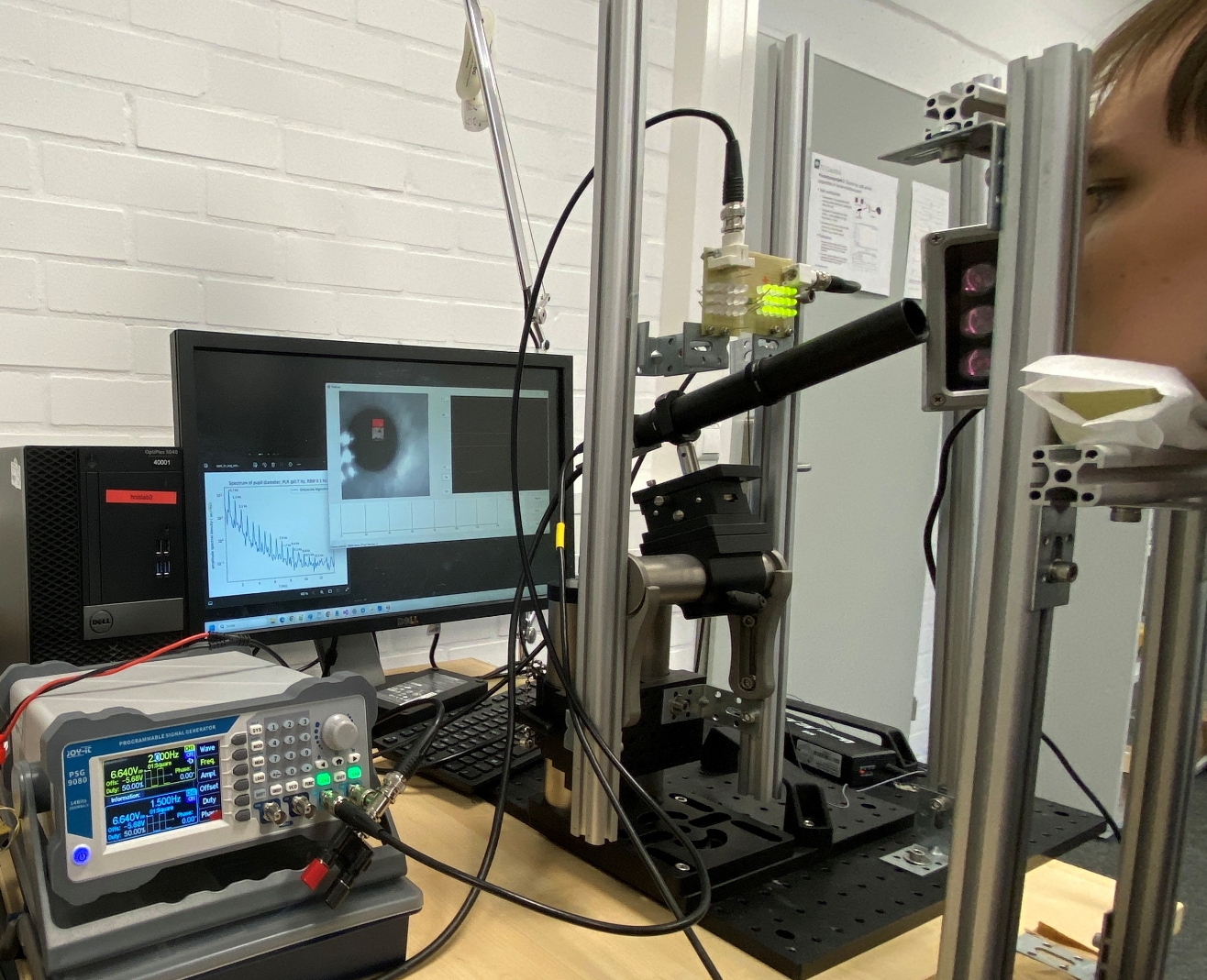

Mitarbeiter Niels Rohweder hat einen Aufbau entwickelt, mit dem sich Korrelationen zwischen nicht direkt sichtbaren Pupillenoszillationen und Gehirnströmen untersuchen lassen. „Wir haben die Auflösung immer weiter verbessert und können inzwischen Gehirnströme in drei Bewusstseinszuständen mit der neuen optischen Technik erfassen“, erklärt er und bezieht sich dabei auf das Delta-, Theta- und Alphaband. In einem ersten Versuch konnte das Clausthaler Team zeigen, dass sich sogar ein Roboter mit Gedanken steuern lässt, indem die Pupillenoszillationen optisch gemessen werden. Derzeit arbeiten die Forschenden daran, mit einer kommerziellen Schwenkneigekamera die Pupille flexibel nachzuverfolgen und zu messen. Ziel des Projektes ist es, dass der Roboter seinem menschlichen Gegenüber kurz in die Augen schaut und dann die aktuellen Emotionen des menschlichen Partners richtig einschätzt.

Abb. 2: Dieser Aufbau mit hochoptimierter Abbildungsoptik ermöglicht es, die Oszillationsamplituden des Pupillendurchmessers im Nanometerbereich zu erfassen. Das korreliert mit den Gehirnströmen und lässt Rückschlüsse auf Bewusstseinszustände wie Müdigkeit zu. (© TU Clausthal)

Weiterführende Informationen

Optisches EEG für Mensch-Maschine-Schnittstellen

Kognitiv und empathisch intelligente kollaborierende Roboter

Forschungseinrichtung

Prof. Dr.-Ing. Christian Rembe

TU Clausthal

Institut für Elektrische Informationstechnik